Intelligenza artificiale e disinformazione

Strumenti utili

Nota bene: l’intelligenza artificiale è un campo in continua evoluzione, per questo motivo questi strumenti sono considerati validi nel dicembre 2024.

- Attraverso la ricerca inversa per immagini di Google possibile risalire al contesto in cui l’immagine (o il frame del video) è stata pubblicata la prima volta.

- “Generative AI and Disinformation: Recent Advances, Challenges, and Opportunities”, un report che fornisce un quadro complessivo del problema della disinformazione legato all’AI generativa, e illustra possibili soluzioni.

- “AI tools for media verification”, un video sugli strumenti di fact-checking sviluppati dal progetto di ricerca AI4MEDIA, e integrati in una versione speciale della piattaforma Truly Media.

- AI4TRUST: un progetto, ancora in sviluppo, che punta a creare una piattaforma attraverso la quale sarà possibile monitorare diversi social media e fonti di informazione in tempo reale.

- “Individuare l’IA: saper riconoscere le immagini reali da quelle dell’IA”, un esercizio per imparare a distinguere un’immagine reale da una generata da intelligenza artificiale.

LA NOSTRA GUIDA

Tutti ne abbiamo sentito parlare, ma come funziona realmente l’intelligenza artificiale (IA)? Si tratta di una tecnologia che insegna ai computer a simulare la comprensione e la risoluzione di problemi, nonché il processo decisionale e la creatività. Negli ultimi anni, la ricerca in questo campo si è focalizzata su quella che è stata definita “intelligenza artificiale generativa”, ossia una “struttura” informatica – meglio nota come modello – che è in grado di comprendere una frase dell’utente (chiamata anche input o prompt) e di generare una risposta (output). Questa “risposta” viene generata sulla base di un processo di apprendimento al quale viene sottoposto il modello.

Il processo di apprendimento si basa su una quantità enorme di dati (per ChatGPT 3.5 si parla di 570 GB di dati) con i quali il modello viene “allenato”. Con una metafora, è come se questo modello venisse esposto ad una enorme biblioteca di testi già scritti, e dopo questo “studio” diventasse “intelligente”. Tale “allenamento in biblioteca” permette al modello di apprendere una serie di regole del linguaggio umano (come quelle grammaticali) ma anche elementi fattuali (ad esempio, Roma è la capitale d’Italia). Sulla base di questi, poi, il modello sarà in grado di elaborare risposte.

Una delle conseguenze del modo in cui è sviluppata l’IA è che essa perpetua gli stereotipi – di genere o razziali – presenti nei dati da cui sta imparando. Se al modello vengono presentate nell’80 per cento dei casi foto di persone bianche e per il 20 per cento foto di persone nere, la “realtà” che il modello avrà “in mente” sarà costituita dall’80 per cento di persone bianche e del 20 per cento di persone nere. Il che, ovviamente, è falso, e non rispecchia la realtà al di fuori dei modelli.

Il fenomeno ChatGPT

Quando è diventato virale a fine 2022, il “fenomeno ChatGPT” ha portato un grande numero di utenti, tra cui moltissimi non esperti, ad interagire direttamente con l’IA in un modo del tutto simile a una conversazione in chat tra esseri umani.

Nel campo dell’informazione, l’enorme interesse per il nuovo strumento ha portato alcune redazioni un po’ da tutto il mondo a sperimentare con la produzione di testi usando l’IA. Tuttavia, di pari passo si è mossa anche la disinformazione.

A marzo 2023 risalgono infatti l’immagine di papa Francesco con un vistoso piumino bianco, ormai iconica, e quella di Donald Trump arrestato e messo in prigione – entrambe false, e create con un programma di IA generativa di immagini di nome Midjourney. Nonostante in entrambi i casi gli autori non avessero alcun intento malevolo, i post sono diventati virali e creduti veri.

La disinformazione e gli stereotipi dell’IA

Nonostante alcuni tipi di immagini e video creati con l’intelligenza artificiale venissero diffusi come disinformazione anche prima del “fenomeno Chat GPT”, i nuovi strumenti hanno reso questa dinamica più intensa. E grazie all’avanzamento dell’intelligenza artificiale, queste creazioni sono diventate sempre più realistiche.

Pensiamo in particolare ai deepfake, ossia una tecnica per la sintesi dell’immagine umana basata sull’intelligenza artificiale che risale già al 2017. Negli ultimi anni, questa tecnica ha dato vita a un prolifico filone di disinformazione, che sfrutta l’immagine di personalità pubbliche per veicolare messaggi falsi e pericolosi.

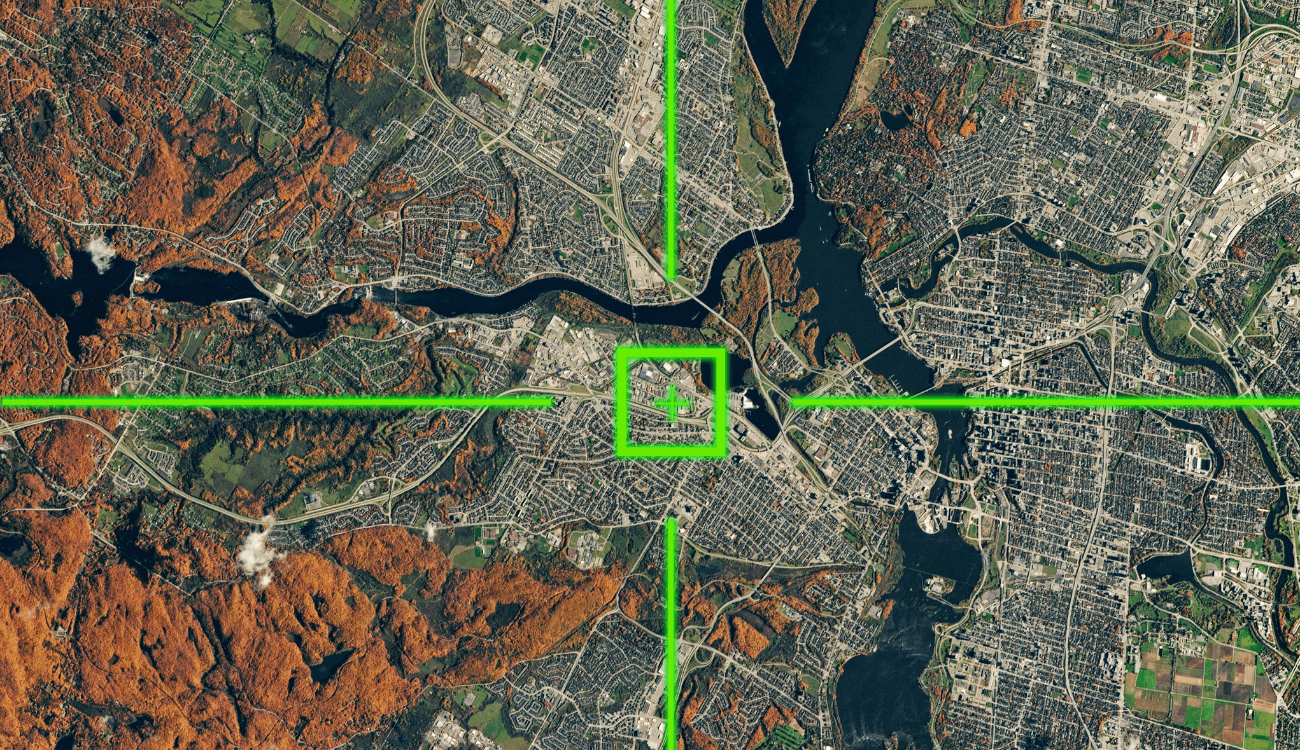

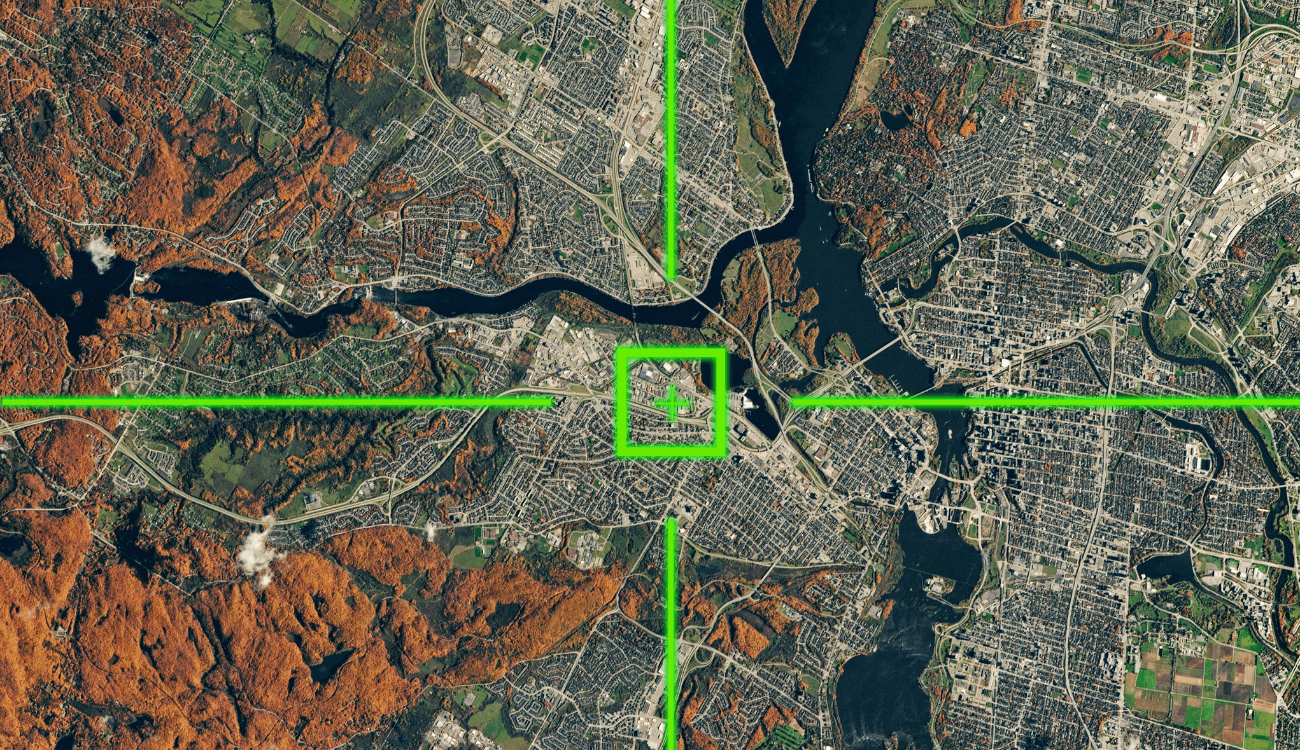

A ottobre 2024, per esempio, è stato diffuso un video di Bill Gates che avrebbe detto di voler ridurre la popolazione mondiale per fermare il cambiamento climatico: era un contenuto creato digitalmente, che diffondeva una notizia falsa. Durante la campagna elettorale statunitense del 2024, invece, erano circolate immagini false per dare l’impressione che il candidato repubblicano Donald Trump fosse una figura molto apprezzata all’interno della comunità afroamericana.

In questi mesi sono stati sviluppati alcuni programmi per verificare se un contenuto è stato generato o meno con l’intelligenza artificiale. Tuttavia, tali strumenti non risultano ancora del tutto affidabili. Per questo non sono affatto rari i casi di disinformazione scaturita da alcune valutazioni errate da parte di questi software, accettate in modo acritico. Posso nascere allora casi di “disinformazione di secondo livello” e la teoria del complotto che mira a dimostrare l’inesistenza di Filippo Turetta, assassino reo confesso di Giulia Cecchettin, è un caso piuttosto esemplificativo di questa dinamica.

Strumenti per riconoscere un contenuto artificiale

Ma quindi, com’è possibile riconoscere i contenuti creati dall’intelligenza artificiale? Innanzitutto, è fondamentale cercare di ricostruire il contesto dell’immagine. Cercare quindi la storia dietro l’immagine stessa. Ad esempio, nel caso di una foto falsa di Rihanna al Met Gala è stato possibile determinarne l’artificialità in base al fatto che la cantante non si trovasse all’evento di New York.

Inoltre, di solito la prima persona che ha condiviso il contenuto è consapevole che si tratti di intelligenza artificiale. Non è raro infatti che le immagini di questo tipo siano pubblicate in canali social finalizzati proprio alla condivisione di contenuti creati con l’IA. In altri casi, al momento di diffonderlo per la prima volta, lo stesso autore dell’immagine ne dichiara l’artificialità. Questo è stato il caso, ad esempio, di una foto di papa Francesco avvolto da una bandiera LGBTQ+. Il testo che accompagnava le immagini alla loro prima condivisione includeva, tra gli altri, l’hashtag #MidJourney (lo strumento basato sull’IA usato per crearla).

Un’altra tecnica consiste nell’identificare loghi o filigrane che a volte vengono posti sulle immagini e permettono di capirne l’origine. Da ultimo, un altro campanello d’allarme è la cura dei dettagli. Infatti, soprattutto nelle rappresentazioni di esseri umani, l’intelligenza artificiale generativa è spesso incapace di rappresentare correttamente dettagli come le dita, i capelli e i pori della pelle. Ma non solo, anche lo sfondo risulta spesso incoerente e non verosimile. A Facta ci siamo imbattuti più di una volta in casi come questi, in cui le persone avevano la pelle troppo lucida e una mano con solo quattro dita.

Vale la pena precisare, comunque, che queste tecniche valgono oggi ma potrebbero non valere tra un anno – o meno – in quanto questa tecnologia è in costante evoluzione e potrebbe diventare ancora più realistica e difficile da individuare.

Opportunità dei modelli di intelligenza artificiale

Ma l’intelligenza artificiale può anche essere usata per contrastare la disinformazione. Sono in corso progetti di ricerca sul rilevamento di contenuti deepfake come Vera.ai, AI4media e AI4TRUST. Quest’ultimo, nello specifico, vuole costruire una piattaforma che monitorerà diversi social media e fonti di informazione in tempo pressoché reale. L’obiettivo è selezionare i contenuti con un alto rischio di disinformazione e segnalarli per la revisione ai fact-checker professionisti.

Il contrasto alla disinformazione potrebbe anche svolgersi su un altro livello. Secondo uno studio pubblicato a settembre 2024 su Science, un chatbot di intelligenza artificiale è stato in grado di modificare le credenze complottiste di migliaia di persone. Il successo di questo studio risiede nel fatto che il chatbot ha utilizzato la stessa strategia impiegata dai complottisti, facendo leva sulle emozioni dei partecipanti e personalizzando il dialogo in base alle loro argomentazioni, per poi confutarle con dati scientifici precisi e pertinenti. Un progetto simile è quello portato avanti dal gruppo di ricerca TITAN, che si propone di combattere la disinformazione creando un’applicazione intelligente che supporta gli utenti alla ricerca della verità su un presunto fatto, basandosi sulla metodologia di dialogo socratica.

In ogni caso, ad oggi l’intelligenza artificiale non rappresenta certo “la soluzione” alla disinformazione online. Come argomentato nel report “IA generativa e disinformazione” dai ricercatori dei progetti che abbiamo menzionato, è necessario – tra le altre cose – che la ricerca faccia ulteriori passi avanti e che i social media collaborino con i ricercatori fornendo loro i dati necessari per studiare le dinamiche della disinformazione e capirne la diffusione.